如何高效整合分散数据,构建统一的实时数据平台

在当今数据驱动的世界中,企业面临的最大挑战之一是如何高效整合分散的数据,并构建一个统一的实时数据平台。分散的数据存储在不同的系统、数据库和云服务中,导致数据孤岛、冗余和不一致,影响业务决策和运营效率。本文将探讨如何通过计算机数据处理及存储服务,高效整合分散数据,构建统一的实时数据平台。

识别并评估现有数据源是整合过程的第一步。企业可能拥有多种数据源,如关系型数据库(如MySQL、PostgreSQL)、NoSQL数据库(如MongoDB、Cassandra)、云存储服务(如AWS S3、Google Cloud Storage)以及实时数据流(如Kafka、Apache Flink)。通过数据目录和元数据管理工具,可以自动发现和记录这些数据源,了解数据的结构、质量和访问权限。这一步有助于减少重复工作,并为后续的整合提供基础。

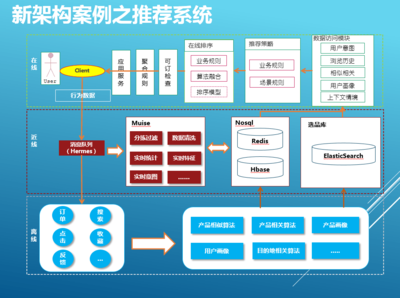

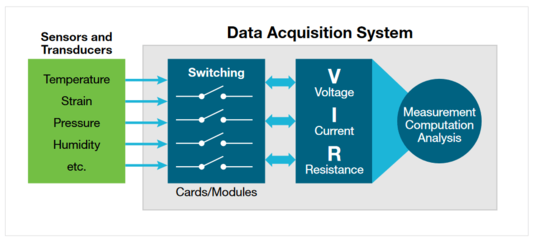

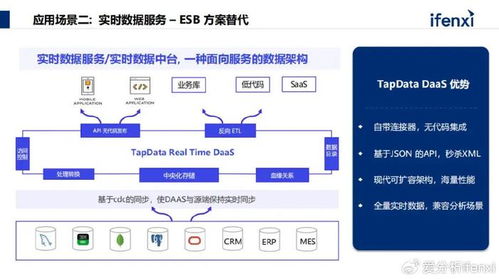

采用统一的数据集成方法是关键。数据集成可以通过ETL(提取、转换、加载)或ELT(提取、加载、转换)流程实现。对于实时数据处理,建议使用流式处理框架,如Apache Kafka或Apache Flink,这些工具能够实时捕获和处理数据流。同时,数据虚拟化技术可以提供一个统一的访问层,无需物理移动数据,从而减少延迟和存储成本。例如,使用工具如Denodo或AWS Glue,可以实现对多个数据源的实时查询和聚合。

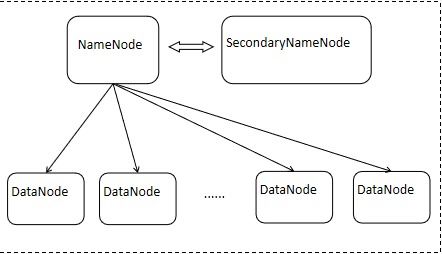

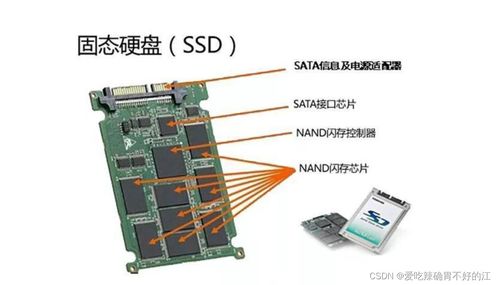

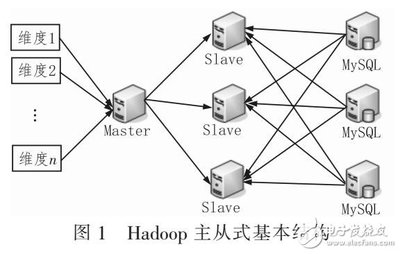

第三,构建可扩展的数据存储架构是确保平台稳定性的基础。统一的实时数据平台应采用多云或混合云存储方案,结合数据湖和数据仓库。数据湖(如基于Hadoop或AWS S3)用于存储原始数据,支持多种数据格式,而数据仓库(如Snowflake、Google BigQuery)则用于结构化数据的分析和查询。通过分层存储策略,可以提高数据访问效率并降低成本。实施数据分区和索引优化,可以加速实时查询性能。

第四,实现数据治理和安全是平台成功的关键因素。在整合数据时,必须确保数据质量、一致性和合规性。使用数据质量工具(如Talend或Informatica)来自动化数据清洗和验证。同时,实施基于角色的访问控制(RBAC)和加密机制,以保护敏感数据。定期审计和监控数据使用情况,可以帮助及时发现和解决安全问题。

第五,利用实时数据处理和分析工具提升业务价值。统一的平台应集成机器学习引擎(如TensorFlow或Apache Spark MLlib),支持实时预测和智能分析。例如,通过实时数据流,企业可以快速识别市场趋势、优化供应链或检测异常行为。仪表板和可视化工具(如Tableau或Grafana)可以提供直观的数据洞察,帮助决策者做出快速响应。

持续监控和优化是确保平台长期高效运行的必要步骤。使用监控工具(如Prometheus或Datadog)跟踪平台性能、数据延迟和资源使用情况。定期进行性能调优和容量规划,以适应业务增长。同时,鼓励团队采用DevOps实践,实现自动化部署和故障恢复,减少人为错误。

高效整合分散数据并构建统一的实时数据平台需要系统化的方法,包括数据源评估、集成策略、存储架构、治理措施和实时分析。通过利用先进的计算机数据处理及存储服务,企业可以打破数据孤岛,提升运营效率,并实现数据驱动的创新。随着技术的发展,持续学习和适应新工具将是保持竞争优势的关键。

如若转载,请注明出处:http://www.zhangyushuju.com/product/886.html

更新时间:2026-02-23 12:55:44